Modelos de Difusão: o que está por trás das imagens mega realistas de inteligência artificial

Cada vez mais temos imagens cada vez mais realistas feitas por inteligência artificial, entenda a técnica que está por trás dessa aplicação.

Nos últimos anos, estamos lidando com um tsunami de inteligência artificial generativa que gera textos, imagens, vídeos e até sons. As imagens e vídeos estão cada vez mais realistas e parte do motivo são os modelos de difusão. Eles têm se destacado por causa da sua capacidade de gerar imagens extremamente realistas. Atualmente, diversas ferramentas como ChatGPT e o Gemini conseguem gerar imagens através de modelos de difusão.

Curiosamente, os modelos de difusão estão extremamente ligados à conceitos matemáticos e físicos sobre caos e ruído. Até o próprio nome tem relação com as ideias iniciais sobre equações de difusão da Física. Os modelos aprendem a partir de dados com ruído e aplica equações de difusão além de processos estocásticos para reconstruir padrões. Com isso, informações aparentemente caóticas podem ser revertidas em dados mais estruturados e a IA aprende a gerar imagens detalhadas.

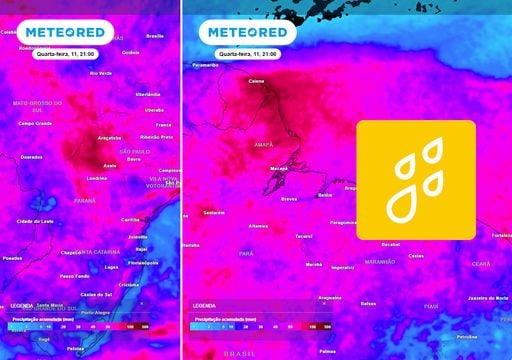

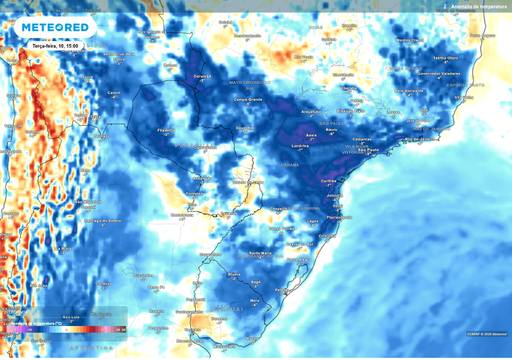

Além das imagens mega realistas que estão ganhando espaço na internet, os modelos de difusão são importantes em aplicações científicas. Eles já são usados para simulações físicas, previsão de estruturas moleculares, análise de imagens médicas e outras tarefas que exigem geração de dados que têm complexidade. Os modelos de difusão permanecem como estado na arte em diferentes frentes da IA.

Modelos de Difusão

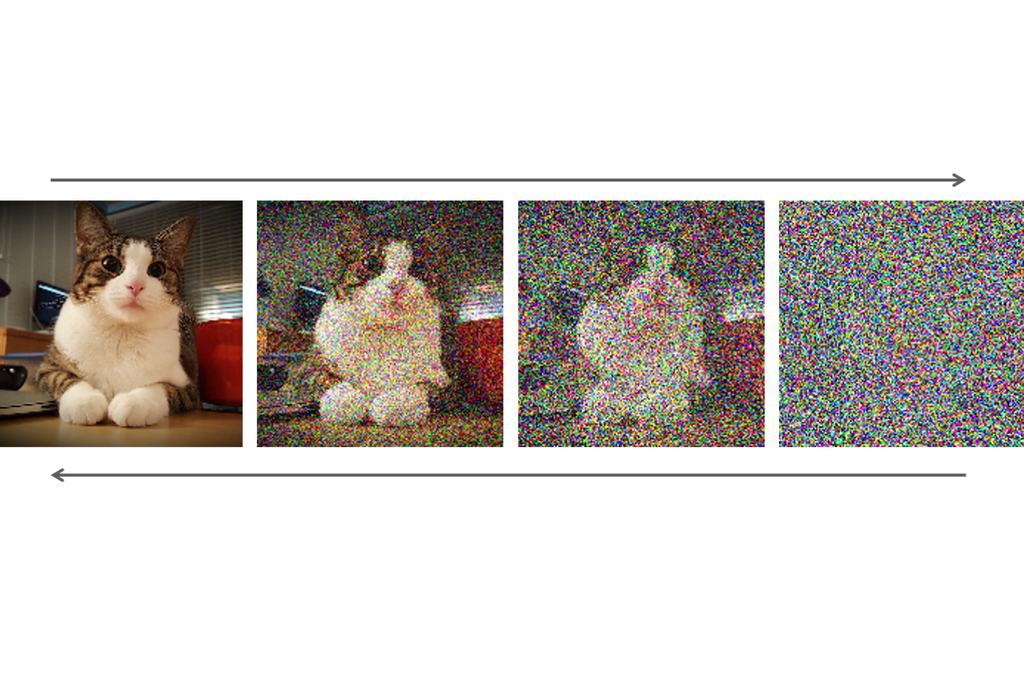

De forma simplificada, os modelos de difusão são modelos de IA que são capazes de gerar dados, como imagens, sons ou vídeos, a partir de informações com ruído no início. Eles funcionam aprendendo a reverter um processo de degradação progressiva onde o dado inicial vai ganhando ruído gradualmente. O modelo observa como esse dado original é transformado até chegar em ruído total. Depois, ele é treinado para reconstruir o dado a partir desse estado ruidoso.

A capacidade dos modelos de difusão em produzir resultados de alta qualidade tornaram esse modelo um dos favoritos das ferramentas hoje em dia. Diferente de modelos anteriores que possuíam limitações, os modelos de difusão conseguem gerar imagens com texturas, cores e estruturas coerentes, ou sons e vídeos com sequência lógica.

Como o ruído cria uma imagem?

O processo de criação de imagens pelos modelos de difusão começa transformando uma imagem real em uma versão gradualmente cheia de ruído. Essa etapa ensina o modelo a entender como a informação visual se degrada com o tempo, criando um caminho reversível que ele poderá usar para reconstruir a imagem original. Ao observar muitas imagens passarem por esse processo, o modelo aprende os padrões necessários.

Na hora de gerar uma nova imagem, o modelo começa com ruído puro e aplica o aprendizado adquirido para remover gradualmente o ruído, passo a passo, até formar uma imagem nítida e detalhada. Cada etapa do processo é guiada pelo conhecimento do modelo sobre como imagens reais se comportam no mesmo processo. É esse “aprendizado reverso do ruído” que permite que modelos de difusão criem imagens realistas a partir da aleatoriedade.

Da Física até a Inteligência Artificial

O conceito de difusão tem suas raízes na Física e na Matemática porque descrevem como partículas, calor ou substâncias se espalham ao longo do tempo em um meio. Essa ideia é descrita por equações diferenciais parciais que modelam a propagação de informação ou matéria. Na Física, a difusão explica fenômenos como o movimento de moléculas em líquidos ou gases, sendo fundamental para entender processos físicos.

Na IA, os cientistas conseguiram adaptar esse conceito para criar modelos capazes de gerar dados complexos. Em vez de partículas físicas, o modelo trabalha com pixels ou sinais que “difundem” informação de forma controlada, aprendendo a reverter o processo e reconstruir padrões realistas. Essa junção da Física com a IA permitiu desenvolver algoritmos generativos mais robustos, capazes de criar imagens, sons e vídeos com alta fidelidade.

Aplicações reais dos modelos de difusão

Apesar de que quando falamos de modelos de difusão, pensamos logo em imagens criadas por ferramentas como ChatGPT e Gemini, os modelos de difusão vão muito além disso. Na Medicina, por exemplo, eles podem gerar imagens sintéticas de alta qualidade para treinamento de algoritmos de diagnóstico. Na Física e Engenharia, esses modelos auxiliam em simulações como dinâmica de fluidos ou comportamento de materiais.

Os modelos de difusão também permitem prototipagem rápida de produtos, imagens ou vídeos, acelerando processos de inovação. Eles também são usados para gerar dados sintéticos para treinar outras IAs, melhorar modelos preditivos e explorar cenários que seriam caros e até mesmo perigosos de testar na prática. Com essas aplicações, a tecnologia tem ajudado em diferentes áreas do conhecimento humano.