Uma Física da IA? Cientistas criam "fase da matéria" para entender como redes neurais aprendem

Pesquisadores usam modelos da física para entender como as redes neurais aprendem e a complexidade delas.

Quando se fala de como redes neurais aprendem, muitas vezes o termo “caixa preta” aparece em analogia com não sabermos o que acontece lá dentro. Embora a descrição do aprendizado de uma rede neural seja conhecida, elas ajustam milhões ou bilhões de parâmetros internos para reconhecer padrões, ainda não se sabe exatamente como essas conexões organizam e processam a informação.

Um dos maiores desafios atuais da inteligência artificial (IA) é compreender em detalhe como essas redes neurais aprendem. A área de Interpretabilidade busca justamente abrir essa “caixa-preta” e explicar o funcionamento interno desses modelos. Isso é importante para compreender seu comportamento e para entender limites e potenciais vieses. Além disso, permite aumentar a segurança e a confiabilidade das aplicações de IA.

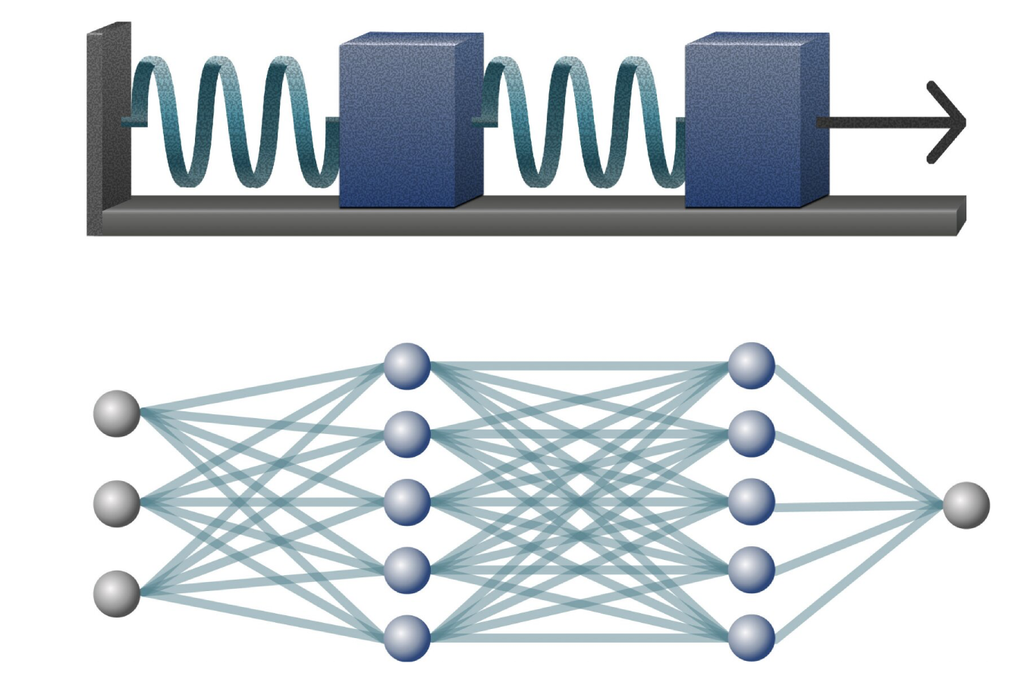

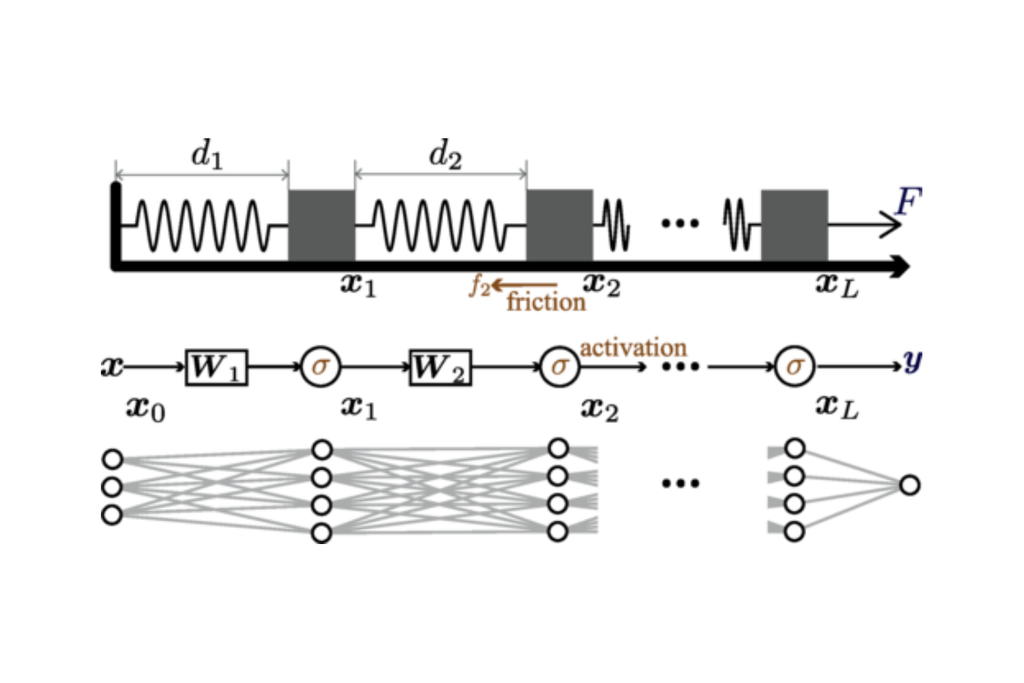

Para avançar nessa compreensão, pesquisadores criaram uma nova ideia de usar Física para conseguir entender o aprendizado de uma rede neural. Eles usaram um modelo físico simples, um sistema de mola-bloco, para fazer analogias entre o processo de aprendizado e o comportamento desse sistema. Essa abordagem permitiu identificar padrões no treinamento das redes neurais e entender como a IA organiza informações.

A "Caixa-Preta" da Inteligência Artificial

As redes neurais tem uma base Matemática que é bem explicada por matemáticos e cientistas da computação. Por trás de cada rede neural tem um processo que envolve Cálculo, Álgebra Linear e Estatística. No entanto, o processo em si envolve milhões ou bilhões de parâmetros que torna extremamente complicado entender como é o aprendizado interno. Por causa disso, o aprendizado frequentemente é chamado de “caixa preta”.

Sabe-se que as camadas de uma rede neural processam informações de forma progressiva, tornando as representações cada vez mais simples. Esse processo é chamado de separação de dados e pesquisadores observaram que essa separação segue padrões previsíveis em algumas condições, mas comportamentos caóticos em outras. A ideia é buscar uma teoria capaz de explicar o que define se a separação será previsível ou caótica.

Analogia com a Física

Um grupo de pesquisadores publicou na Physical Review Letters um estudo onde usaram sistemas físicos para conseguir explicar como as redes neurais aprendem. Mais especificamente, o grupo usou um sistema simples conhecido como sistema mola-bloco para explicar a dinâmica do aprendizado. O sistema se refere a blocos interligados por molas onde interações lineares e não-lineares têm efeito.

Nessa analogia, cada camada da rede neural é um bloco e a conexão entre as camadas é representada pela mola. A forma como a rede simplifica os dados corresponde à extensão de uma mola. Já a não-linearidade presente na rede é representada pelo atrito entre os blocos e a superfície. Eles descobriram que, assim como uma cadeia de mola-bloco responde a uma força de tração, a rede neural responde a quanto ela errou na sua previsão, separando os dados camada por camada.

Uma fase da matéria

A analogia possibilitou a criação de um diagrama de fases que descreve como diferentes níveis de não-linearidade e ruído influenciam o aprendizado. Os pesquisadores identificaram que o ruído desempenha um papel durante o treinamento de uma rede neural. Assim como em um sistema oscilatório onde vibrações podem distribuir melhor a energia, o ruído nas redes neurais pode contribuir para que a separação de dados seja mais equilibrada ao longo das camadas.

Isso possibilita entender como o ruído deve ser considerado durante um treinamento e que em vez de ter como objetivo apenas redução dele, ele pode atuar como um regularizador próprio da rede. Dessa forma, ele funcionaria como regularizadores que servem para ajudar na generalização do modelo e prevenir o overfitting. O diagrama de fases serve como uma ferramenta para ajustar parâmetros de forma mais organizada.

O Futuro da Inteligência Artificial

Com a introdução dessa nova perspectiva com uso de sistema análogo na Física, isso abre um caminho para a área de Interpretabilidade em compreender e otimizar redes neurais. O interessante é que mesmo com um sistema simples, que envolve poucos parâmetros físicos, é possível descrever o funcionamento de arquiteturas com bilhões de parâmetros. Essa abordagem pode reduzir o custo e o tempo necessários para treinar modelos gigantes.

Além disso, a analogia abre portas para realização de diagnósticos mais sofisticados, capazes de identificar problemas, como o risco de overfitting. Algo semelhante seria os mapas de estresse que os engenheiros usam para evitar falhas em estruturas. A Física já tem sido usada há décadas como uma forma de ajudar a criar designs de IA tanto de software quanto de hardware cada vez melhores.

Referência da notícia

Shi et al. 2025 Spring-Block Theory of Feature Learning in Deep Neural Networks Physical Review Letters