Será que modelos de linguagem conseguem classificar imagens astronômicas? Entenda novo estudo

Artigo que foi publicado na Nature Astronomy analisa como modelos de linguagem podem analisar imagens astronômicas

Nas últimas décadas, a Astronomia passou a enfrentar um obstáculo que não existia há 1 século atrás. Antes, o problema da Astronomia era a falta de dados, enquanto hoje, com o avanço da tecnologia, o problema se tornou a quantidade gigante de dados sendo obtidos diariamente. Observatórios produzem terabytes de informações por dia e as simulações computacionais exigem enorme poder de processamento, tornando o gerenciamento, análise e interpretação desses dados um problema na área.

Para lidar com esse aumento de dados, a Inteligência Artificial tem se tornado uma ferramenta cada vez mais importante na Astronomia. Modelos de aprendizado de máquina têm sido aplicados para classificar galáxias, identificar exoplanetas, detectar anomalias em curvas de luz e até acelerar simulações cosmológicas. Técnicas de visão computacional e aprendizado não supervisionado permitem encontrar padrões e correlações que escapam à análise humana.

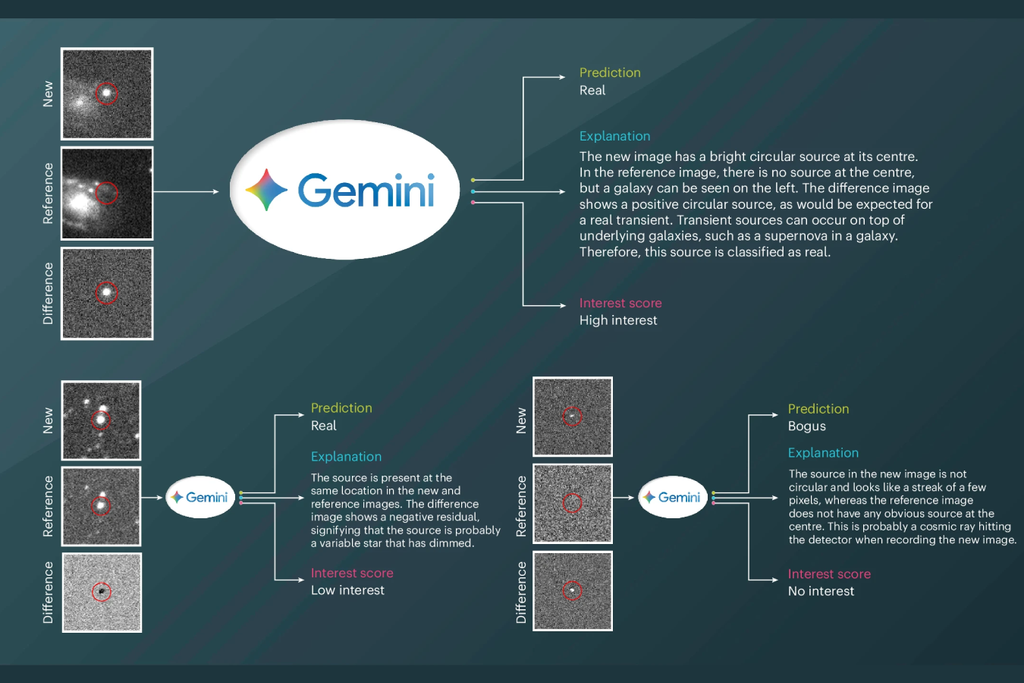

Um estudo recente publicado na Nature Astronomy mostrou como os modelos de linguagem podem analisar dados astronômicos, em especial o Gemini. Os pesquisadores testaram o modelo em tarefas de classificação de imagens astronômicas e observaram que ele foi capaz de identificar objetos e padrões com precisão comparável aos métodos tradicionais. Essa pesquisa mostra como modelos originalmente criados para compreender linguagem passam a atuar também como ferramentas visuais com aplicação até científica.

Modelos de linguagem

Modelos de linguagem são modelos de inteligência artificial que foram criados para compreender, gerar e manipular texto. Eles são treinados com grandes volumes de dados textuais para aprender padrões linguísticos como estrutura gramatical, semântica e contextos. Esses modelos conseguem gerar textos e até prever a próxima palavra em uma sequência, responder perguntas, traduzir idiomas e resumir informações.

Nos últimos anos, os modelos de linguagem evoluíram passando de sistemas baseados em regras simples para arquiteturas com bilhões de parâmetros. Eles até expandiram e conseguem integrar outras formas de dados, como imagens, áudio e código. Atualmente, modelos como ChatGPT, Gemini e Claude estão sendo cada vez mais usados para uma série de tarefas.

Como classificar imagens astronômicas?

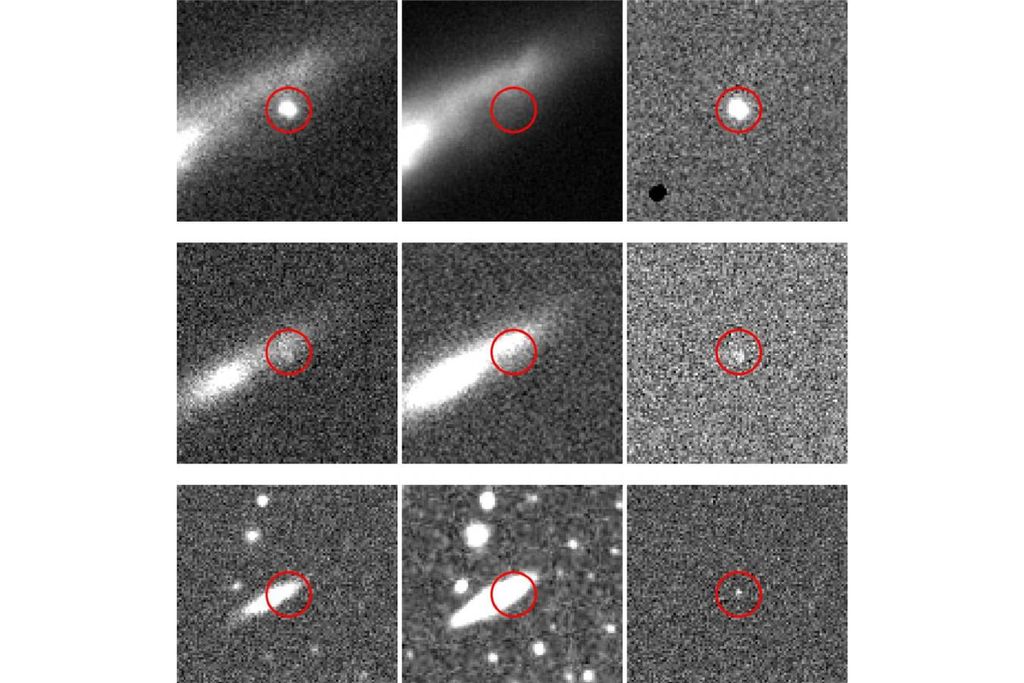

O início de classificação de imagens astronômicas através de modelos de inteligência artificial usando redes neurais convolucionais (CNNs). Essas redes foram implementadas para analisar padrões visuais e processar imagens sem perder informações. Com isso, elas logo foram escolhidas como as técnicas para identificar objetos astronômicos e até realizar simulações após serem alimentadas com grande volume de dados.

As CNNs funcionam extraindo características das imagens por meio de camadas convolucionais que detectam bordas, texturas e estruturas complexas. As CNNs são capazes de reconhecer anomalias, detectar fenômenos raros e até estimar propriedades físicas de objetos astronômicos, como massa, distância e luminosidade. Elas foram amplamentes usadas nos primeiros estudos do uso de inteligência artificial na Astronomia.

Analisando com modelos de linguagem

Modelos de linguagem de grande escala (LLMs) estão começando a revolucionar a forma como imagens astronômicas são classificadas. As CNNs fazem as operações em espaços latentes complexos e pouco interpretáveis, o que dificulta entender por que uma classificação foi feita. Em contraste, as LLMs demonstraram ser capazes de atingir níveis de desempenho comparáveis aos das CNNs com uma precisão média de 93%.

O Gemini foi testado usando três tipos de dados com origens dos observatórios Pan-STARRS, MeerLICHT e ATLAS. Os pesquisadores usaram apenas 15 exemplos e instruções em linguagem natural. Os LLMs não apenas classificam as imagens, mas também geram descrições textuais sobre o que foi observado. Isso permite entender o raciocínio por trás de cada classificação diferente do que acontece com as CNNs.

Como modelos de linguagem conseguem analisar?

LLMs conseguem classificar imagens ao combinar técnicas de visão computacional com compreensão de linguagem natural. Eles utilizam uma arquitetura chamada de multimodal que é treinada para processar tanto texto quanto imagens. Com isso, esses modelos conseguem aprender relações entre padrões visuais e descrições linguísticas. Um modelo treinado consegue analisar elementos visuais e gerar uma descrição textual coerente.

O grande diferencial dos modelos de linguagem é a interpretação. Em vez de apenas rotular uma imagem como “galáxia” ou “estrela”, o LLM pode justificar sua decisão descrevendo detalhes observáveis, como “estrutura espiral” ou “região brilhante indicando uma supernova”. Além disso, o uso de LLMs permite definir instruções específicas sem reescrever o modelo ou treinar novamente. Essa capacidade de adaptação torna os LLMs ferramentas interessantes para usar na classificação de imagens.

Referência da notícia

Stoppa et al. 2025 Textual interpretation of transient image classifications from large language models Nature Astronomy