Inteligência artificial conseguiu se passar por humano! Veja resultados do teste de Turing

Estudo colocou em prova algumas das Inteligências Artificiais (IA) generativas do mercado para saber se passaria no teste de Turing.

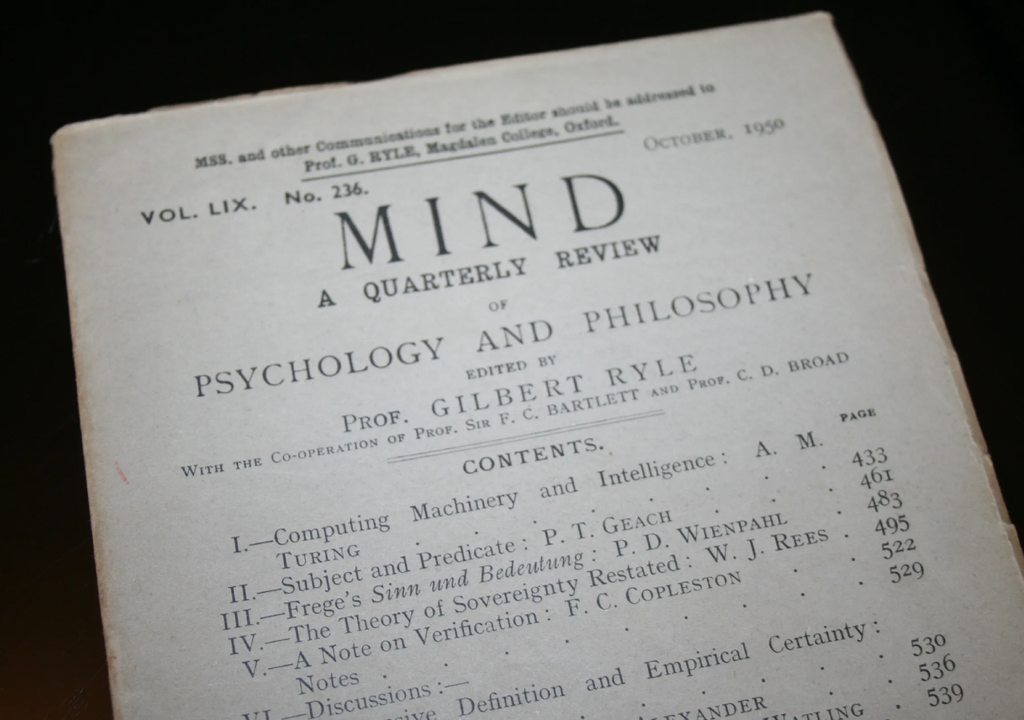

Em 1950, o cientista da computação Alan Turing, publicou um artigo seminal intitulado "Computing Machinery and Intelligence". Neste trabalho, ele propõe a ideia de thinking machines ou máquinas pensantes além de um experimento mental para abordar a questão de se máquinas poderiam "pensar". Em vez de definir intelig��ncia de forma direta, Turing sugeriu um teste prático que ficou conhecido como o 'Teste de Turing'.

O Teste de Turing envolve um avaliador humano que interage por meio de texto com um ser humano e uma máquina que estão ocultos. Se o avaliador não conseguir distinguir a máquina do humano com base em suas respostas, a máquina é considerada como tendo passado no teste. Esse teste visa demonstrar a capacidade de uma máquina de exibir comportamento inteligente equivalente ao de um ser humano.

Um estudo recente investigou o desempenho de modelos de inteligência artificial (IA) generativa no Teste de Turing. Os pesquisadores submeteram quatro modelos de linguagem à interações textuais com avaliadores humanos, buscando determinar se essas IAs conseguiam enganar os participantes. Os resultados desse estudo ajudam a entender em qual estágio estamos em relação à capacidade das IAs de simular a inteligência humana na comunicação.

Teste de Turing

O Teste de Turing foi proposta pelo cientista da computação Alan Turing em 1950 como uma estratégia para avaliar a capacidade de uma máquina exibir comportamento inteligente equivalente ao de um ser humano. No mesmo artigo, Turing também introduz a ideia de máquinas pensantes ou thinking machines que seria a primeira ideia por trás da inteligência artificial que conhecemos hoje.

O objetivo do Teste de Turing não é definir o que é inteligência, seja natural ou artificial. Mas ser possível ter critério operacional para determinar se uma máquina consegue simular a inteligência humana durante uma conversa. Apesar do objetivo ser apenas o foco na conversação, alguns criticam o teste argumentando que ele não aborda outras formas de inteligência ou consciência.

Como funciona?

O Teste de Turing funciona com um avaliador humano que se comunica apenas por texto com duas figuras ocultas. Uma dessas figuras é um ser humano enquanto a outra figura é uma máquina, ou seja, modelos de linguagem como conhecemos. O avaliador humano faz perguntas e analisa as respostas de ambos, sem saber qual é qual. Ao final do teste, o avaliador tem que classificar qual figura é o humano e qual é máquina.

Se, após um período de interação, o avaliador não conseguir distinguir a máquina do humano com uma precisão significativamente maior que o acaso, diz-se que a máquina passou no Teste de Turing. O mesmo é válido se a máquina for classificada como humana de forma errada. Esses resultados sugeriram que a máquina demonstrou uma capacidade de gerar respostas indistinguíveis das de um ser humano na conversação.

Novo estudo

Um novo estudo da Universidade Cornell avaliou quatro sistemas de IA generativa, (ELIZA, GPT-4o, LLaMa-3.1-405B, e GPT-4.5 no Teste de Turing. Cada participante tinha 5 minutos para conversar simultaneamente com outro ser humano e com um desses modelos antes de classificar. O modelo GPT-4.5 da OpenAI, ao ser instruído a adotar uma pessoa humana, conseguiu enganar 73% dos avaliadores, sendo identificado como humano na maioria das vezes.

Os outros modelos que foram testados apresentaram resultados variados: o Llama 3.1, que é o modelo de linguagem da Meta, foi considerado humano em 56% das vezes. Já a versão GPT-4o da OpenAI e o chatbot Eliza obtiveram taxas de identificação como humano abaixo do acaso, com 21% e 23%, respectivamente.

O que concluir disso?

O estudo foi feito com 284 participantes humanos e mostrou o desempenho do modelo GPT-4.5 da OpenAI. Resultados preliminares e que ainda não foram revisados por pares indicam que o GPT-4.5 passou no teste de Turing quando foi instruído a simular uma persona humana. A taxa de 73% mostra que o modelo consegue interagir praticamente como um humano em conversação.

O Llama 3.1 da Meta também demonstrou capacidade de persuasão, sendo considerado humano em 56% das interações. O estudo argumenta que os resultados representam a primeira evidência de que um sistema de inteligência artificial superou o Teste de Turing. O sucesso do GPT-4.5 em enganar uma maioria dos avaliadores, ao adotar uma persona humana, marca um avanço significativo na capacidade das IAs generativas.

Referência da notícia

Large Language Models Pass the Turing Test. 31 de março, 2025. Cameron R. Jones e Benjamin K. Bergen.